Analyse und Synthese von hoch interaktivem Verhalten zur Optimierung von Mensch-zentrierten technischen Wahrnehmungsprozessen

Die fortschreitende Automatisierung wie z.B. in der Produktion wird u.a. durch den verstärkten Einsatz von Industrierobotern vorangetrieben. Der Mensch soll in diesen interaktiven, hochautomatisierten Umgebungen auch in Zukunft eine tragende Rolle einnehmen. Jedoch mangelt es an guten technischen Interaktionsmodellen, mit denen menschliches Verhalten antizipiert und eine gefahrenlose Zusammenarbeit zwischen Mensch und Maschine gewährleistet werden kann.

Aus Gründen der Unfallvermeidung existiert bisher eine weitestgehend klare Trennung zwischen robotischen und menschlichen Arbeitsplätzen. Um industriegerechte Mensch-zentrierte Automationsumgebungen zu entwickeln, ist eine neue Anlage realisert worden - Motion-Capture-4.0 (MoCap 4.0). Sie wurde zu großem Teil vom Bundesministerium für Bildung und Forschung (BMBF) finanziert. Mit ihr sind neue Erkenntnisse über die Interaktion in automatisierten Umgebungen zu erwarten.

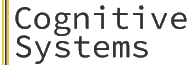

In der Anwendung beschäftigen wir uns u.a. mit technischen Wahrnehmungsprozessen zur Umsetzung des autonomen Fahrens. Im Fokus stehen dabei Funktionen zur Erkennung von Fußgängern sowie die Vorhersage ihrer Intentionen. Erkenntnisse in diesem Bereich übertragen wir auf den industriellen Anwendungsfall und auf digitale Arbeitswelten. Um Aussagen darüber treffen zu können, wie ein Mensch interagieren möchte, und welche Reaktion ein Mensch in welcher Situation erwartet, ist es notwendig, feinste Bewegungsmerkmale zu erfassen und zu deuten. Unerwartete Situationen können dabei nur durch intelligent gesteuerte Interaktionstechnologien abgesichert werden, in der mensch-zentrierten Simulationen eine wichtige Komponente darstellen.

MoCap 4.0 setzt sich aus mehreren Komponenten zusammen: einem hochgenauen optischen Trackingsystem, mobilen Eye-Trackern, einem 3D-Scanner, sowie diversen Feedback-generierenden Komponenten, wie z.B. VR-Datenbrillen. Mit dieser Ausstattung ist es möglich, Bewegungsmerkmale, z.B. in Bereichen hoher Interaktionsgrade mit autonomen Maschinen oder Assistenzsystemen, zu erfassen. Aufbauend auf einer intelligenten Analyse (Maschinelles Lernen) und Synthese (Simulation) der anfallenden Datenströme, können neue sensorbasierte Verfahren entworfen werden, die die Interpretation menschlicher Bewegungen in Umgebungen auch außerhalb des Labors übernehmen und entsprechende Reaktionen einer Maschine auslösen.

Kontextadaptive Bewegungserkennung: Die entwickelten Funktionen zur Interpretation menschlicher Bewegungsmerkmale dienen der Ermittlung relevanter Informationen zur Definition von technologischen Anforderungen im Kontext von Industrie 4.0 und weiteren digitalen Arbeitswelten. Die Erkenntnisse sind anwendungsneutral, d.h. sie sollen ebenso auf Entwicklungsprozesse im individualisierten medizinisch-technischen Bereich der Rehabilitation und Assistenz nach Schlaganfall übertragen lassen, wie auch der Mensch-zentrierten Vorentwicklung von Interiors autonomer Fahrzeuge dienen.

Basic dataProject LeadTeam